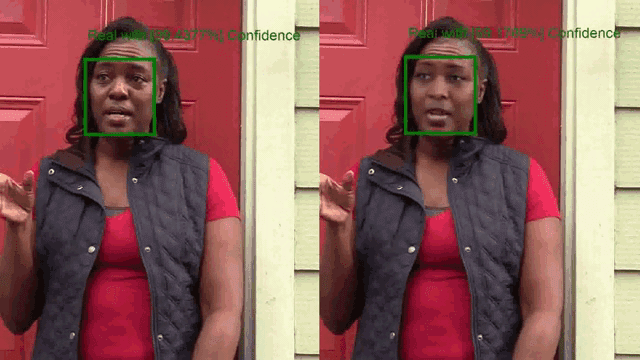

Il problema dei deepfake si fa sempre più pressante, anche se c’è chi, come Disney, pensa a sfruttare la tecnologia per migliorare gli effetti speciali. Con le elezioni presidenziali sempre più vicine negli USA, Microsoft entra ora in gioco presentando strumenti dedicati in grado di separare i contenuti “fake” da quelli legittimi.

L’obiettivo di Microsoft è utilizzare l’intelligenza artificiale per combattere le manipolazioni (sempre a base di IA) note come deepfake, contenuti falsati in cui il volto di una persona viene modificato, alterato o anche sostituito su un video pre-esistente. Il volto fake potrà quindi essere programmato per dire qualsiasi cosa sia di interesse per il manipolatore.

Contro i deepfake, Microsoft ha sviluppato una nuova tecnologia chiama Video Authenticator. Il sistema è addestrato a riconoscere le piccole, spesso impercettibili sbavature o manipolazioni nei video e nelle immagini, fornendo poi un punteggio che valuti il livello potenziale di manipolazione artificiale.

Altre tecnologie contro la disinformazione sviluppate da Microsoft includono poi un tool di autenticazione basato su Azure, in grado di verificare (tramite hash digitale) l’autenticità di un contenuto Web contro le fake news, e un’estensione per browser pensata per effettuare la verifica lato-client.